“什么是公平”,就算是人类自己也没有统一的标准,它有时取决于语境。不论是在家里,还是在学校,教导小孩要公平是至关重要的,但说起来容易做起来难。正因为如此,我们要如何才能将社会上所说的“公平”的细微差别传递给人工智能(AI)系统呢?

IBM研究院的一组研究人员是着手解决该难题的先驱。IBM为开发人员推出了一款名为“AI Fairness 360”的工具包。作为这项工作的一部分,IBM为企业提供一种新的“基于云的、偏差(bias)检测和消除服务”,企业可以使用它来测试和验证AI驱动的系统的行为。

在接受EE Times的电话采访时,IBM研究院院士SaskaMojsilovic告诉我们,科学家和AI从业者太过于关注AI的准确性。通常,人们关于AI的第一个问题是,“机器可以击败人类吗?”

但公平呢?例如,AI中的公平缺位可能会导致在医疗保健中或自动驾驶车辆造成灾难性后果,她说。

如果用于训练机器的数据集有偏差怎么办?如果AI无法解释它是如何做出决定的,那么我们怎样才能验证其“正确性?”AI可以揭示在AI处理过程中数据是否被以某种方式操纵过吗?AI是否可以向我们保证其数据从未(包括处理前和处理后)受到攻击或篡改吗?简言之,是否存在AI内省?简单回答:没有。

Mojsilovic表示,如果不对AI用户、开发人员和从业者开放,AI系统就无法获得社会的信任。

分解公平

一个更大的问题是如何教导机器什么是公平。Mojsilovic指出,“因为我们是科学家,我们做的第一件事就是分解‘公平’。我们需要从这着手。”他们将公平分解为AI实现中的指标、算法和偏差。

IBM研究科学家Kush Varshney解释说,其团队研究了AI算法和AI决策的偏差和公平性。“有个人的公平,也有团体的公平。我们研究了群体的不同属性——从性别到种族。还考虑了法律和监管问题。”最后,团队最终测量了30个不同的指标,以寻找数据集、AI模型和算法中的偏差。

这些发现已纳入IBM不久前推出的AI Fairness 360工具箱中。IBM将其描述为“一个全面的指标开源工具包,用于检查数据集和机器学习模型中不期望的偏差。”

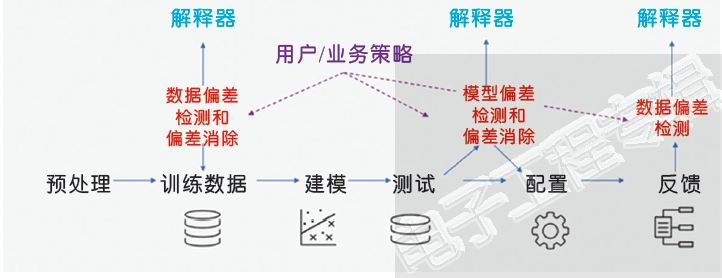

图片翻译:解释器;数据偏差检测和偏差消除;用户/业务策略;模型偏差检测和偏差消除;数据偏差检测;预处理;训练数据;建模;测试;配置;反馈

虽然许多科学家已经在努力发现AI算法中的歧视(discrimination),但Mojsilovic说IBM的方法不同,它不仅包括发现偏差的算法,且还包括用于消除偏差的工具。

在基础层面,你必定会问:由计算机科学家——定义公平?这通常不是社会科学家的活吗?意识到这种不搭调,IBM明确表示Mojsilovic和Varshney都没有闭门造车。他们引入了许多学者和研究机构。Varshney参加了由卡内基国际事务伦理委员会主办的Uehiro-Carnegie-Oxford伦理会议。 Mojsilovic参加了由加州大学伯克利分校法学院赞助的加州伯克利人工智能工作组。

算法中立吗?

一段时间以来,社会科学家一直在指出AI偏差问题。

威斯康星大学麦迪逊分校新闻与大众传播学院教授Young Mie Kim解释说,“AI歧视(或AI偏差)可能发生在它隐含或明确地强化现有不平等的社会秩序和偏见(例如,性别、种族、年龄、社会/经济状况等)时。”例子从抽样误差(例如,由于抽样方法的不适当或困难导致某些人口统计数据不充分)到机器训练(建模)中的人为偏差。 Kim认为,即使在设计或建模中采用的“战略决策”也存在AI偏差,例如政治广告算法。

在她最近题为“算法机会:数字广告和政治参与的不平等”的研究中,Kim展示了在基于算法的决策中不平等是如何被强化的。

技术社区可能会争辩说“算法是中立的”或者可以“受过教育”(训练有素)。 Kim指出,“也就是说,他们并不承认在算法开发的任何阶段都会出现偏差。”

可解释的AI

不只是消费者害怕AI。许多计算机科学家也表达了担忧。

威斯康星大学计算机科学助理教授AwsAlbarghouthi告诉EE Times,“从短期看,我担心越来越多地使用数据驱动的决策,这有可能传播偏见和不公正。从长远看,我担心AI在战争自动化方面的使用。”

AI无法解释其决策带来持续焦虑。威斯康星大学计算机科学助理教授Loris D'Antoni告诉我们,“现在,程序员开始将强大的机器学习算法作为编程工具箱中的工具。然而,这些算法复杂、难以预测、难以解释。例如,没人知道由此产生的机器学习模型究竟做了什么。在他看来,“总的来说,自动化决策需要被理解和规范,并且可能以正规的方式进行。”

对于流程的每个步骤,从训练数据和处理到测试和部署,IBM指出其工具包提供的解释 可显示:在两种决策中、哪些因素倾向于支持哪一方;对推荐的信心以及支持这种信心的因素。

IBM希望AI Fairness 360工具包将被广泛使用,以便开发人员可以为其做出贡献,帮助建立对AI的信任。

与此同时,IBM将为企业提供其新的软件服务,旨在自动检测偏差并解释AI在需要做决策时,是如何做出决策的。它在IBM Cloud上运行,可帮助企业管理AI系统。

IBM称,其在IBM Cloud上的公平性监控服务将与来自各种机器学习框架模型和AI构建环境(如Watson、TensorFlow、SparkML、AWS SageMaker和AzureML)配合使用。“这意味着组织可以借力这些新控制以服务于企业使用的大多数流行的AI框架,”IBM称。IBM也承诺提供定制服务。“还可对软件服务进行编程,以监控任何业务工作流程的独特决策因素,使其能够根据特定的组织用途进行定制。”

好的开始

越来越意识到AI中算法公平问题的AI研究界,对IBM的新产品表示欢迎。威斯康星大学的计算机科学家D'Antoni告诉我们,“看到公平检查技术进入业界并付诸实践,真的令人兴奋。”他补充道,“我认为该工具将使AI研究界更加意识到该问题的重要性。”

Albarghouthi称IBM的努力“开了个好头”。

但是为了让AI Fairness 360工具包真正变得有效,应该使许多需要理解它的开发人员能用到它。Albarghouthi解释说,该工具需要“与研究界探索的最新的公平技术共同发展。”

他告诫说,“如果研究和理解超越了目前的定义和技术,”那么该工具很可能会停滞不前。

公平问题

最后,任何成全或破坏AI公平工具包的因素都会回溯到如何定义公平这一棘手问题。IBM的Mojsilovic承认,在不同应用中,公平有不同表现。正如人类对公平有不同看法,用户、客户和公众可能会根据情况对公平有不同评判。

当被问及AI公平工具包的缺陷时,Albarghouthi表示,问题之一是“存在于公平性定义的选择以及其是否足够。”毕竟,公平“在很大程度上取决于领域、其敏感性和涉及的监管。”他补充说:“我确信,这些工具只有在其使用成为机器学习管道的标准部分时才有效。”

D'Antoni表达了他自己的担忧。“有很多关于公平和偏差的定义,很难将它们全部考虑在内且其实现也并非能毕其功于一役。”换句话说,“公平定义往往是‘冲突的,’他说。“存在的不可能出现的结果表明,某些公平概念不能同时诉诸实施。”

此外,还有一个事实是“机器学习社区目前尚未接受过如何了解现有的公平和偏差定义的含义以及如何使用它们,”他补充道。

社会科学家Kim同意。“对这种[AI偏见]问题的认识是抗击AI歧视的第一步,也是最重要的一步。”她指出,“在人类社会中,我们提出了一些减轻不平等和歧视的政策和法规。但问题是AI仍是个秘密。与大多数情况一样,数据和建模是专有的。这使得任何公共政策或监管讨论/辩论更加困难。“

透明度

理解了定义公平性时的复杂性和权衡取舍之后,IBM研究人员认为,优先事项应该是AI实践和实施的透明度。

IBM的Mojsilovic建议由AI服务开发商和提供商完成并自愿发布供应商的符合性声明(她称之为情况说明书)“以提高其服务的透明度并产生对它们的信任。”她将其比作“食品营养标签”,或“器具信息表”。

业界需要有关部署在不同服务中的AI系统信息的标准。 IBM敏锐地意识到这不会在一夜之间发生。正如营养标签花了很长时间才逐步发展起来一样,情况说明书的开发可能是个漫长过程。Mojsilovic警告说,业界才刚刚开始其人工智能之旅。

与IBM类似,研究界也在与AI公平问题斗争。在这个悬而未决的领域,IBM的AI Fairness工具箱似乎具有开创性。 D'Antoni告诉我们,“我不知道现有的用于AI模型的通用公平检查工具。”

另一方面,他补充说,“研究界提出了许多令人兴奋的原型工具。例如,Kramer等人提出的FairTest和来自我们自己团队的FairSquare。”